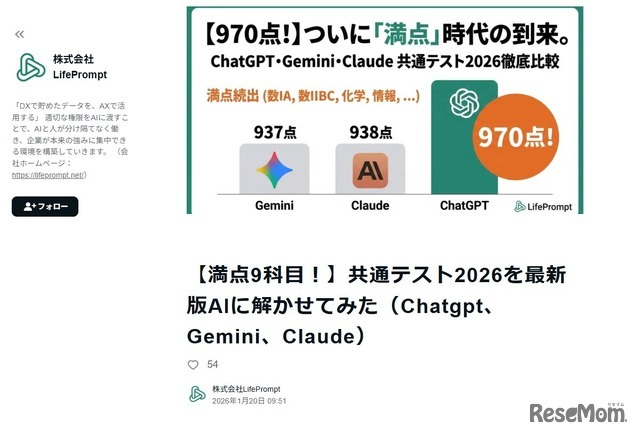

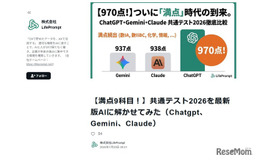

LifePromptは2026年1月、最新の生成AI3モデルに2026年度の大学入学共通テスト全科目を受験させる実験を実施した。9科目で満点を達成したものの、イラスト問題や色の濃淡を読み取る問題では誤答し、視覚情報処理に課題があったという。

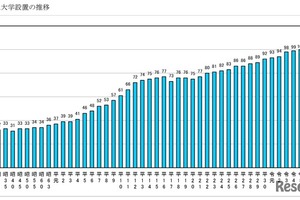

LifePromptは2023年から毎年、最新AIに大学入学共通テスト(以下、共通テスト)を受験させる実験を継続している。2023年は「生成AI」が流行語大賞に選ばれ、2025年には「チャッピー」がノミネートされるなど、AIは3年間で日常生活に深く浸透した。2025年の実験では、AIが東大合格ラインを突破したが、2026年はさらに次元が異なる結果となった。

今回の実験は、GPT-5.2 Thinking、Gemini 3 Pro、Claude 4.5 Opusの3モデルで行った。英語(リーディング・リスニング)、国語(現代文・古文・漢文)、数学(数学I・A/数学II・B・C)、社会(歴史総合・世界史探究/歴史総合・日本史探究/地理総合・地理探究/公共・政治・経済)、理科(物理・化学)、理科基礎(物理基礎・化学基礎・地学基礎・生物基礎)、情報(情報I)の全科目を対象とした。

人間によるコピペミスや恣意性を完全に排除するため、同企画専用の自動受験システムを開発し、API経由で試験を実施した。なお、英語リスニングは音声データの直接入力が難しいため、試験センターが公開している「読み上げスクリプト(台本)」をテキストで入力。国語(縦書き)は、事前に外部ツール(NotebookLM)で文字起こししたテキストデータを使用したという。

全科目の得点結果は、文系・理系ともにGPT-5.2 Thinkingが圧勝した。文系では900点台後半、理系でも同様の高得点を記録し、GeminiとClaudeが900点台前半で激しく競り合う形となった。一方で、解答時間はGeminiとClaudeが1時間40分前後で、試験時間10時間10分の約6分の1という速度で完走したのに対し、GPTは5時間30分程かかり、明暗がくっきり分かれた。

満点科目は、英語リーディング、国語(現代文)、数学I・A、数学II・B・C、歴史総合・世界史探究、歴史総合・日本史探究、地理総合・地理探究、物理、化学の9科目で達成した。

一方で、3モデルのAIが共通して間違えた問題が存在した。もっとも多くのモデルがつまずいたのが、「テキストは完璧に理解できているのに、図が選べない」という現象だという。象徴的だったのが、英語リスニングの「バスの乗り方」(問18-21)だ。音声スクリプトでは「後ろから乗って、前から降りる」とはっきり指示されており、すべてのAIが思考ログでこの手順を完璧に書き起こしていた。しかし、いざ選択肢の「バスのイラスト(矢印が前後のドアに向いている図)」を選ぶ段になると、全モデルが誤答した。AIにとって、イラストの微妙な矢印の意味や、空間的な奥行きを論理と結びつけるのは、まだ至難の業のようだ。

LifePromptは「AI vs 東大受験企画」を始動。「東大理III合格」を成し遂げた2025年に続き、「2年連続合格」を果たすことで、その知性が本物であることを証明するという。

![転職を決めた本当の理由とは…Teacher’s[Shift]](/imgs/p/7UQJZRUXmPkVIZBOtGebBtTX_9gR2tvc3d7f/41196.jpg)